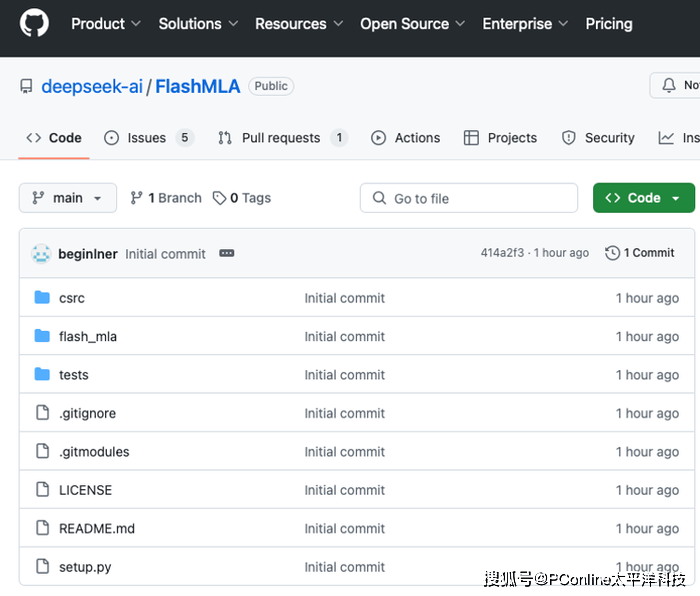

國內人工智能領域的領軍者DeepSeek正式拉開了其開源周的序幕,而今日發布的FlashMLA項目無疑在AI技術界掀起了軒然大波。這一專為英偉達Hopper架構GPU量身打造的高效解碼內核,不僅將H800 GPU的性能推向了新的巔峰,更是被譽為大模型推理服務的突破性加速器。

FlashMLA的核心優勢在于其針對大語言模型(LLM)解碼過程的深度優化。通過巧妙地重構內存訪問和計算流程,它顯著提升了變長序列處理的效率。這一設計的靈感雖然源自業界知名的FlashAttention 2&3和cutlass項目,但FlashMLA在分塊調度和內存管理上實現了更為卓越的突破。

更令人矚目的是,FlashMLA還擁有兩大性能絕技。其一是分頁KV緩存技術,采用頁式內存管理策略,有效減少了顯存碎片化問題,使得H800上的內存帶寬飆升至驚人的3000 GB/s,特別適用于高并發推理場景。其二是BF16精度支持,這一特性在計算密集型任務中實現了精度與速度的完美平衡,單卡算力高達580 TFLOPS,相較于傳統方案,性能提升超過30%。

DeepSeek官方透露,FlashMLA已經成功應用于實際生產環境,能夠支持從聊天機器人到長文本生成的各類實時任務,為AI應用的商業化落地提供了即插即用的解決方案。這一成果不僅彰顯了DeepSeek的技術實力,也預示著AI技術在實際應用中的巨大潛力。

在開源周的預熱階段,網友們紛紛猜測DeepSeek接下來的開源項目。有人甚至大膽預測,開源周的第五天或許會揭曉AGI(通用人工智能)的神秘面紗。這一推測背后,折射出DeepSeek構建“模型-開發者-軟硬件”一體化生態的雄心壯志。通過開源降低技術門檻,吸引更多開發者參與,同時推動技術方案的標準化和商業化應用,DeepSeek正逐步搶占AI領域的制高點。

值得注意的是,FlashMLA的發布不僅標志著DeepSeek在AI技術上的重大突破,也揭示了整個AI行業的兩大發展趨勢。一方面,軟硬件協同優化成為提升AI性能的關鍵路徑。FlashMLA的成功實踐表明,“特供”芯片與高效解碼內核的結合能夠釋放出巨大的算力潛能。另一方面,開源成為推動AI技術普及和應用的重要力量。通過開源擴大影響力,吸引更多開發者參與,共同推動AI技術的標準化和商業化進程。

與此同時,AI領域的競爭也日益激烈。蘋果與Google Gemini的合作宣布,進一步加劇了AI基座之爭。在這個充滿機遇與挑戰的時代,DeepSeek通過開源周的一系列重磅項目,不僅展示了自身在AI技術上的深厚積累,也向業界傳遞了一個明確的信號:在通往通用人工智能的道路上,中國方案正加速前行。