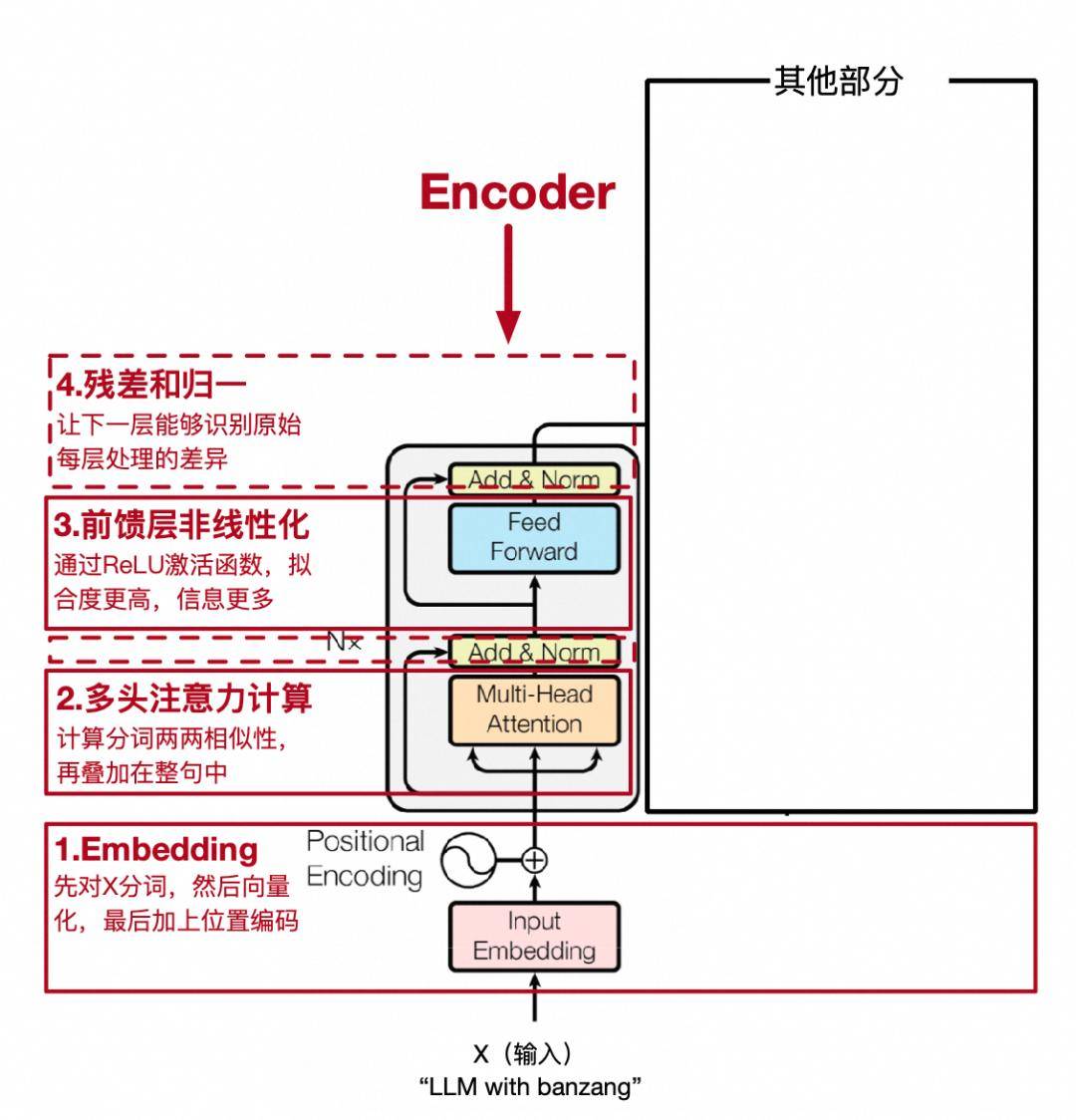

在深度學習領域,模型訓練過程中的性能優化一直是一個備受關注的話題。特別是在處理復雜任務如自然語言理解時,模型的每一層網絡都會增加計算負擔,可能導致梯度下降過程中的不穩定現象。梯度在下降過程中,有時會跳過最優解,或在最優解附近徘徊,這不僅消耗了大量計算資源,還可能影響模型的最終性能。

為了解決這一問題,研究者們不斷探索新的網絡架構。2015年,微軟亞洲研究院提出的ResNet架構,在卷積神經網絡中引入了“跳躍連接”的概念,為Transformer模型提供了靈感。這種連接允許梯度直接反向傳播到更原始的層,從而有效緩解了網絡深度帶來的“退化”問題。在Transformer中,輸入X不僅被傳遞給每一層進行處理,還通過跳躍連接直接與該層的輸出Y相加。這種設計使得后續層能夠學習到當前層處理與原始輸入之間的差異,而非僅僅依賴于上一層的處理結果。這種機制允許網絡學習到恒等映射,即輸出與輸入相同,為模型提供了更簡單的路徑來學習正確的映射關系。

在實現跳躍連接時,由于X和Y的維度相同,因此可以直接相加。然而,為了確保相加操作的有效性,通常需要對每一層的輸出進行歸一化處理。這一過程包括計算矩陣每行的均值和方差,然后用每行的元素減去均值并除以標準差(為了避免除以零的情況,通常會加上一個小的常數)。最后,通過引入可訓練的參數a和b,來抵消歸一化過程中可能引入的損失。

經過跳躍連接和歸一化處理后,Transformer模型的第一階段處理基本完成。為了增加模型的非線性表達能力,通常會再添加一個非線性層,即一個簡單的全連接神經網絡。這一層通過權重矩陣和偏置項對輸入進行線性變換,并引入非線性激活函數,從而使模型能夠學習到更豐富的特征表示。之后,模型還會再次進行歸一化處理,以確保輸出的穩定性。

Transformer模型的這一階段被封裝為一個獨立的模塊,稱為編碼器(Encoder)。編碼器能夠捕捉句子中每個詞與整個句子的關聯性,使得每個詞向量都包含了句子中所有詞的信息以及它們之間的關聯度。這一特性使得Transformer模型在自然語言處理任務中表現出色,尤其是在機器翻譯、文本生成等領域。