在上海浦東張江科學會堂,一場聚焦于人工智能前沿技術(shù)的盛會——智譜開放平臺產(chǎn)業(yè)生態(tài)大會圓滿舉行。會上,智譜公司震撼發(fā)布了其最新科研成果,一款名為GLM-4.1V-Thinking的新一代通用視覺語言模型。

本次大會不僅見證了技術(shù)的革新,還迎來了資本的重磅加持。智譜公司宣布,浦東創(chuàng)投集團與張江集團將共同向其注入總額高達10億元的戰(zhàn)略投資,且首筆資金已順利交割。三方攜手啟動了一項旨在構(gòu)建人工智能新型基礎(chǔ)設(shè)施的合作項目,為人工智能的未來發(fā)展奠定了堅實基礎(chǔ)。

GLM-4.1V-Thinking模型是智譜公司精心打造的一款多模態(tài)輸入通用推理型大模型,專為應(yīng)對復(fù)雜認知任務(wù)而生。它不僅能夠處理圖像、視頻、文檔等多種數(shù)據(jù)類型,還在GLM-4V架構(gòu)的基礎(chǔ)上融入了創(chuàng)新的“思維鏈推理機制”,通過“課程采樣強化學習策略”,顯著提升了模型的跨模態(tài)因果推理能力和運行穩(wěn)定性。

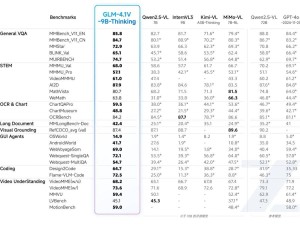

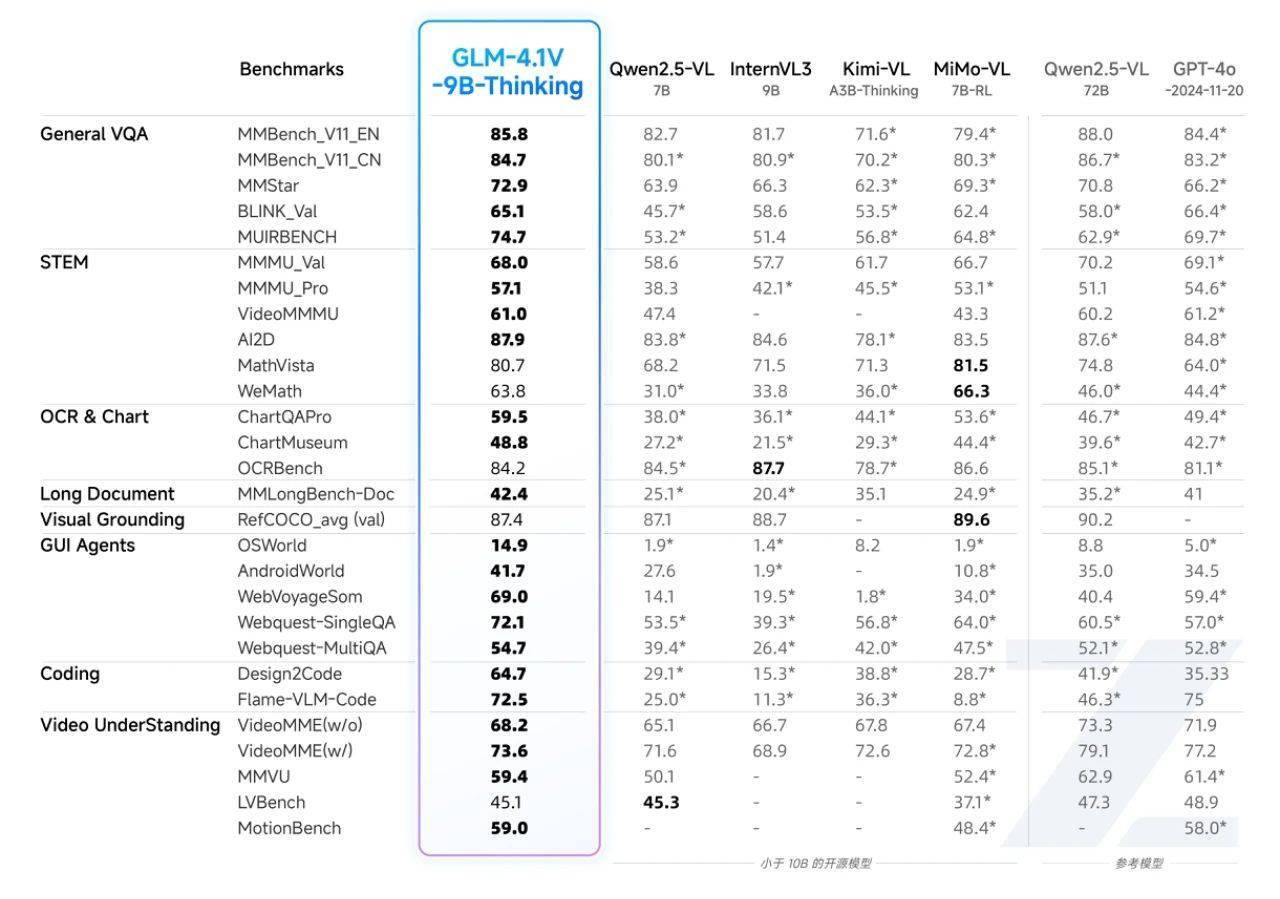

值得注意的是,GLM-4.1V-Thinking的輕量版——GLM-4.1V-9B-Thinking,在保持模型參數(shù)控制在10B級別的同時,實現(xiàn)了性能上的重大突破。在MMStar、MMMU-Pro、ChartQAPro、OSWorld等28項權(quán)威評測中,該模型取得了23項10B級模型的最佳成績,其中有18項表現(xiàn)甚至與參數(shù)量高達72B的Qwen-2.5-VL相當或更優(yōu),充分證明了其在小體積下展現(xiàn)出的極限性能潛力。

GLM-4.1V-9B-Thinking模型在多個任務(wù)領(lǐng)域均展現(xiàn)出卓越的通用性和穩(wěn)健性。在圖文理解方面,它能夠精準識別并綜合分析圖像與文本信息;在數(shù)學與科學推理領(lǐng)域,它支持復(fù)雜題解、多步演繹與公式理解;在視頻理解方面,它具備時序分析與事件邏輯建模能力;在GUI與網(wǎng)頁智能體任務(wù)中,它能夠理解界面結(jié)構(gòu),輔助自動化操作;在視覺錨定與實體定位方面,它實現(xiàn)了語言與圖像區(qū)域的精準對齊,極大地提升了人機交互的可控性。

為了讓更多研究者能夠探索視覺語言模型的能力邊界,GLM-4.1V-9B-Thinking已在Hugging Face與魔搭社區(qū)同步開源。開源的版本包括GLM-4.1V-9B-Base基座模型和具備深度思考和推理能力的GLM-4.1V-9B-Thinking模型,用戶可正常使用和體驗后者。